Big data hakkında her şeyi öğrenmeye hazır mısınız? Her gün dünyanın farklı bölgelerinden insanlar sosyal medya platformlarını, mobil uygulamaları ve web sitelerini çeşitli amaçlarla kullanıyor. Bu platformları sadece gezinti yapmak amacıyla kullandığınızı düşünüyorsanız yanılıyorsunuz. Gezinirken sistemlerin veri tabanlarına birçok veri gönderilir. Yapılan işlemler, geçirilen süreler, sosyal medya beğenileri hangi, yapılan yorumlar, izlenenler… Örneğin bir istatistiğe göre her gün 500 terabayttan fazla yeni veri Facebook’un veri tabanlarına kaydediliyor.

Bir uygulamayı açtığımızda, Google’da arama yaptığımızda veya mobil cihazlarımızla bir yere seyahat ettiğimizde sürekli olarak üretilen bu verilerin sonucunda ne olur? Şirketlerin ve kuruluşların yönetmesi, depolaması, görselleştirmesi ve analiz etmesi gereken devasa değerli bilgi koleksiyonları ortaya çıkar. Geleneksel veri araçları, bu yükü yönetmek için tasarlanmış bir dizi özel büyük veri yazılımı bu tür karmaşıklık ve veri hacminin üstesinden gelecek şekilde donatılmamıştır.

Büyük veriye giriş yapmadan önce veri nedir onu açıklığa kavuşturalım. Veri, elektrik sinyalleri şeklinde saklanabilen ve iletilebilen ve manyetik, optik veya mekanik kayıt ortamlarına kaydedilebilen, bilgisayar tarafından işlemlerin gerçekleştirildiği miktarlar, karakterler veya sembollerin tümüdür.

Big Data Nedir?

Büyük veri, bir bakıma “tüm veriler” anlamına gelir. Bir zamanlar geleneksel yöntemlerle işlenmesi kolay olmayan büyük veri kümeleridir. Büyük verinin en kısa tanımı, bilgisayarların işleyemeyeceği kadar büyük olan veridir. Yani bu veri sürekli olarak büyüyen bir veridir.

Big Data kavramı nispeten yenidir ve şu anda toplanan verilerin hem artan miktarını hem de değişen türlerini temsil etmektedir. Büyük veri savunucuları buna genellikle dünyanın ‘tarihlendirmesi’ olarak atıfta bulunur. Dünyanın daha fazla bilgisi çevrimiçi hale geldikçe ve dijitalleştikçe bu, analistlerin onu veri olarak kullanmaya başlayabilecekleri anlamına geliyor.

Çevrimiçi Yaptığınız Her Şey Artık Veri Olarak Saklanıyor ve İzleniyor

Kindle’ınızda bir kitap okumak, ne okuduğunuz, ne zaman okuduğunuz, ne kadar hızlı okuduğunuz vb. hakkında veriler üretir. Benzer şekilde, müzik dinlemek ne dinlediğiniz, ne zaman ve hangi sırayla dinlediğiniz hakkında veri üretir. Akıllı telefonunuz sürekli olarak nerede olduğunuz, ne kadar hızlı hareket ettiğiniz ve hangi uygulamaları kullandığınız hakkında veri yükler. Akılda tutulması gereken önemli bir nokta da, büyük verinin yalnızca ürettiğimiz veri miktarıyla ilgili olmadığı, aynı zamanda tüm farklı veri türleri (metin, video, arama günlükleri, sensör günlükleri, müşteri işlemleri vb.) ile ilgili olmasıdır.

Big Data 7V’si Nedir?

Big Data ilk zamanlarda üç V ile karakterize edildi: Volume, variety, velocity. Bu özellikler ilk olarak 2001 yılında, daha sonra danışmanlık firması Meta Group Inc.’de analist olan Doug Laney tarafından tanımlandı. Gartner, 2005’te Meta Group’u satın aldıktan sonra bunları daha da popüler hale getirdi.

- Volume (Hacim): Hacim, büyük verinin başlıca özelliği olmakla birlikte depolanan büyük miktarda veridir. Bir büyük veri ortamının büyük miktarda veri içermesi gerekmez. Ancak çoğu, toplanan ve depolanan verilerin doğası gereği böyledir. Tıklama akışları, sistem günlükleri ve akış işleme sistemleri, sürekli olarak büyük miktarda veri üreten kaynaklar arasındadır. Big Data ayrıca çok çeşitli veri türlerini kapsar. İşlemler ve mali kayıtlar gibi yapılandırılmış veriler; metin, belgeler ve multimedya dosyaları gibi yapılandırılmamış veriler ve web sunucusu günlükleri ve sensörlerden gelen akış verileri gibi yarı yapılandırılmış veriler.

- Velocity (Hız): Hız, verilerin üretildikten sonra işlenmesi ve analiz edilmesi gereken hızı ifade eder. Çoğu durumda, büyük veri kümeleri, birçok geleneksel veri ambarında yapılan günlük, haftalık veya aylık güncellemeler yerine gerçek veya neredeyse gerçek zamanlı olarak güncellenir. Big Data analizi, analitik süreçlerin otomatik olarak verilerdeki kalıpları bulduğu ve bunları iç görü oluşturmak için kullandığı makine öğrenimi ve yapay zekâya ( AI ) doğru genişlediğinden, veri hızını yönetmek de önemlidir.

- Variety (Çeşitlilik): Sayılar, metin, video, resim, ses ve metin gibi verilerin toplandığı farklı kaynaklar ve formlar. Tüm büyük verilerin kabaca %95’i yapılandırılmamış, yani basit, geleneksel bir modele kolayca sığmıyor. E-postalardan ve videolardan bilimsel ve meteorolojik verilere kadar her şey, her biri kendine özgü özelliklere sahip büyük bir veri akışı oluşturabilir.

- Veracity (Doğruluk): Doğruluk, veri kümelerindeki doğruluk derecesini ve ne kadar güvenilir olduklarını ifade eder. Çeşitli kaynaklardan toplanan ham veriler, tespit edilmesi zor olabilecek veri kalitesi sorunlarına neden olabilir. Veri temizleme süreçleriyle düzeltilmezlerse, kötü veriler, iş analitiği girişimlerinin değerini azaltabilecek analiz hatalarına yol açar. Veri yönetimi ve analitik ekiplerinin de geçerli sonuçlar üretmek için yeterli doğru veriye sahip olduklarından emin olmaları gerekir.

- Variability (Değişkenlik): Verinin anlamı sürekli değişmektedir. Yapılandırılmamış verilerdeki kelimelerin anlamı bağlama göre değişebilir. Örneğin, bilgisayarlar tarafından dil işleme son derece zordur çünkü kelimelerin çoğu zaman birkaç anlamı vardır. Veri bilimcileri, bağlamı ve anlamı anlayan karmaşık programlar oluşturarak bu değişkenliği hesaba katmalıdır.

- Visualization (Görselleştirme): Veriler herkes tarafından anlaşılabilir olmalıdır. Veriler analiz edildikten sonra, kullanıcıların anlaması ve buna göre hareket etmesi için bir görselleştirmede sunulması gerekir. Görselleştirme, veri bilimcisinin hikâyesini anlatan, verileri bilgiye ve bilgiyi hikâyeye dönüştüren karmaşık verilerin görselleştirilmesidir.

- Value (Değer): Verilerin yararlı olması için titiz işleme ve analizlerle birleştirilmesi gerekir.

Büyük veride kaç V’yi tercih ederseniz edin, kesin olan bir şey var: Büyük veri burada ve giderek büyüyor. Her kuruluşun, büyük verinin kendileri için ne anlama geldiğini ve onlara nasıl yardımcı olabileceğini anlaması gerekir. Olasılıklar gerçekten sonsuzdur.

Big Data Neden Önemlidir?

Şirketler, operasyonlarını iyileştirmek, daha iyi müşteri hizmeti sağlamak, kişiselleştirilmiş pazarlama kampanyaları oluşturmak ve karları artırabilecek diğer eylemleri gerçekleştirmek için sistemlerinde büyük verileri kullanır. Bunu etkin bir şekilde kullanan işletmeler, daha hızlı ve daha bilinçli iş kararları verebildikleri için, kullanmayanlara göre potansiyel bir rekabet avantajına sahiptir.

Örneğin büyük veri, şirketlerin müşteri katılımını ve dönüşüm oranlarını artırmak amacıyla pazarlama, reklam ve promosyonlarını sunmak için kullanabilecekleri müşterilere ilişkin değerli bilgiler sağlar. Tüketicilerin veya kurumsal alıcıların gelişen tercihlerini değerlendirmek için hem geçmiş hem de gerçek zamanlı veriler analiz edilebilir, bu da işletmelerin müşteri istek ve ihtiyaçlarına daha duyarlı hale gelmelerini sağlar.

Büyük veri, neredeyse her sektörde kalıpları ve eğilimleri belirlemek, soruları yanıtlamak, müşteriler hakkında bilgi edinmek ve karmaşık sorunların üstesinden gelmek için kullanılır. Şirketler ve kuruluşlar, bilgileri işlerini büyütmek, müşteri kararlarını anlamak, araştırmayı geliştirmek, tahminler yapmak ve reklamcılık için kilit kitleleri hedeflemek gibi birçok nedenden dolayı kullanır.

Kuruluşlar Tarafından Big Data Nasıl Kullanılıyor?

Finans

Finans ve sigorta endüstrileri, diğer kullanımların yanı sıra dolandırıcılık tespiti, risk değerlendirmeleri, kredi sıralamaları, aracılık hizmetleri ve blok zinciri teknolojisi için büyük veri ve tahmine dayalı analitiği kullanır. Finansal kurumlar ayrıca siber güvenlik çabalarını geliştirmek ve müşteriler için finansal kararları kişiselleştirmek için büyük verileri kullanıyor.

Sağlık Hizmeti

Hastaneler, araştırmacılar ve ilaç şirketleri, sağlık hizmetlerini iyileştirmek ve ilerletmek için Big Data çözümlerini kullanıyor. Hasta nüfus verilerine erişim sayesinde var olan tedavileri yöntemleri geliştiriliyor; kanser ve Alzheimer gibi hastalıklar üzerinde daha etkili araştırmalar yapılıyor ve yeni ilaçlar geliştiriliyor. Büyük veriler ayrıca tıp araştırmacıları tarafından hastalık belirtilerini ve risk faktörlerini belirlemek, doktorlar tarafından hastalardaki hastalıkları ve tıbbi durumları teşhis etmeye yardımcı olmak için kullanılır. Ek olarak elektronik sağlık kayıtları, sosyal medya siteleri, web ve diğer kaynaklardan elde edilen veriler sağlık kuruluşlarına ve devlet kurumlarına bulaşıcı hastalık tehditleri veya salgınlar hakkında güncel bilgiler verir.

Medya ve Eğlence

Daha önce Netflix, Hulu veya öneriler sunan diğer akış hizmetlerini kullandıysanız, büyük verinin iş başında olduğuna tanık olmuşsunuz. Medya şirketleri, kişiselleştirilmiş deneyimler oluşturmak için okuma, izleme ve dinleme alışkanlıklarımızı analiz eder. Netflix, müşteri tercihleriyle ilgili kararlar almak için grafikler, başlıklar ve renkler hakkındaki verileri bile kullanır.

Tarım

Ziraat mühendisliğinden mahsul verimini şaşırtıcı bir doğrulukla tahmin etmeye kadar büyük veri ve otomasyon, tarım endüstrisini hızla geliştirmek için kullanılır. Avrupa ülkelerinin birçoğu bu sayede tarımda teknolojik gelişmeleri daha iyi kullanır hale geldi. Son yirmi yılda veri akışıyla birlikte birçok ülkede bilim insanları ve araştırmacılar açlık ve yetersiz beslenmeyle mücadele etmek için büyük verileri kullanmaya yöneliyor. Küresel beslenme ve tarımsal verilere açık ve sınırsız erişimi destekleyen Tarım ve Beslenme için Küresel Açık Veri (GODAN) dünyadaki açlığı sona erdirme mücadelesinde araştırmacılara kolaylık sağlıyor.

Dolandırıcılık Tespiti ve Önlenmesi

Kredi kartı şirketleri birçok dolandırıcılıkla karşı karşıyadır ve bunları tespit etmek ve önlemek için Big Data teknolojileri kullanılmaktadır. Daha önceki kredi kartı şirketleri tüm işlemleri takip eder ve şüpheli bir işlem tespit edilirse alıcıyı arayarak işlemin yapılıp yapılmadığını teyit ederdi. Ancak şimdi satın alma kalıpları gözlemleniyor ve dolandırıcılıktan etkilenen alanlar büyük veri analitiği kullanılarak analiz ediliyor. Bu, dolandırıcılıkların önlenmesinde ve tespit edilmesinde çok faydalıdır.

Hava Durumu

Big Data teknolojileri, hava durumunu tahmin etmek için kullanılır. İklim hakkında büyük miktarda veri beslenir ve hava durumunu tahmin etmek için bir ortalama alınır. Bu, sel vb. doğal afetleri tahmin etmek için faydalı olabilir.

Kamu Sektörü

Büyük veri, birçok hükümette ve kamu sektöründe kullanılmaktadır. Büyük veri, güç araştırması, ekonomik tanıtım vb. gibi birçok olanak sağlar. Diğer hükümet kullanımları arasında acil müdahale, suç önleme ve akıllı şehir girişimleri yer alır.

Enerji endüstrisinde büyük veri, petrol ve gaz şirketlerinin potansiyel sondaj yerlerini belirlemesine ve boru hattı operasyonlarını izlemesine yardımcı olur; benzer şekilde, kamu hizmetleri bunu elektrik şebekelerini izlemek için kullanır. Üreticiler ve nakliye şirketleri, tedarik zincirlerini yönetmek ve teslimat rotalarını optimize etmek için büyük verilere güveniyor.

Big Data Örnekleri: Veri Tabanları, Belgeler, E-Postalar…

Büyük veriler sayısız kaynaktan gelir. Örneğin müşteri veri tabanları, belgeler, e-postalar, tıbbi kayıtlar, internet tıklama akışı günlükleri, mobil uygulamalar ve sosyal ağlar, kişiselleştirilmiş e-ticaret alışveriş deneyimleri, finansal piyasa modellemesi, kanser araştırmalarını hızlandırmak için trilyonlarca veri noktası derlemek, Spotify, Hulu ve Netflix gibi akış hizmetlerinden medya önerileri, çiftçiler için mahsul verimini tahmin etmek, şehirlerdeki tıkanıklığı azaltmak için trafik kalıplarını analiz etme, perakende alışveriş alışkanlıklarını ve optimum ürün yerleşimini tanıyan veri araçları.

Dahili sistemlerden gelen verilere ek olarak, büyük veri ortamları genellikle tüketiciler, finansal piyasalar, hava ve trafik koşulları, coğrafi bilgiler, bilimsel araştırmalar ve daha fazlası hakkında harici verileri içerir. Görüntüler, videolar ve ses dosyaları da büyük veri biçimleridir ve birçok büyük veri uygulaması, sürekli olarak işlenen ve toplanan akış verilerini içerir.

Big Data Terimleri

Kaçınılmaz olarak, büyük veri etrafındaki kafa karışıklığının çoğu, çevresinde ortaya çıkan yeni (çoğu için) terimlerin çeşitliliğinden kaynaklanmaktadır. Big Data terimleri arasında en popüler olanlardan bazıları:

- Algoritma (Algorithm): Verileri analiz etmek için yazılım tarafından çalıştırılan matematiksel formül

- Amazon Web Services (AWS): İşletmelerin, şirket içinde depolama veya işlem gücüne ihtiyaç duymadan büyük ölçekli bilgi işlem işlemlerini gerçekleştirmesine yardımcı olan bulut bilişim hizmetleri koleksiyonu

- Cloud (Bulut-Bilgi işlem): Yazılımı yerel olarak değil uzak sunucularda çalıştırmak

- Hadoop: Çok büyük veri kümelerinin depolanmasına, alınmasına ve analizine izin veren programların toplamı

- Internet of Things (Nesnelerin interneti): Kendi verilerini (genellikle insan girişi olmadan) toplayan, analiz eden ve ileten nesneleri (sensörler gibi) ifade eder.

- Predictive Analytics (Tahmine dayalı analitik): Eğilimleri veya gelecekteki olayları tahmin etmek için analitiği kullanma

- Structured v Unstructured data (Yapılandırılmış v Yapılandırılmamış veri): Yapılandırılmış veri, aynı tablodaki diğer verilerle ilişkili olması için bir tabloda düzenlenebilen herhangi bir şeydir. Yapılandırılmamış veriler, yapılamayacak her şeydir.

- Web scraping (Web kazıma): Web sitelerinden verilerin toplanmasını ve yapılandırılmasını otomatikleştirme süreci (genellikle kod yazarak)

Big Data Nasıl Kullanılır?

Büyük verinin çeşitliliği, onu doğası gereği karmaşık hale getirerek, çeşitli yapısal ve anlamsal farklılıklarını işleyebilen sistemlere ihtiyaç duyulmasına neden olur. Büyük veri, verileri belirli bir modele sıkı sıkıya bağlı kalmayı gerektirmeyen bir şekilde depolayabilen özel NoSQL veritabanları gerektirir. Bu, ne olup bittiğine, nasıl hareket edileceğine ve ne zaman hareket edileceğine dair bütünsel bir görüş elde etmek için görünüşte farklı bilgi kaynaklarını tutarlı bir şekilde analiz etmek için gereken esnekliği sağlar.

Big Data Nasıl Saklanır?

Büyük veriler genellikle bir veri havuzunda depolanır. Veri ambarları genellikle ilişkisel veri tabanları üzerine kurulur ve yalnızca yapılandırılmış veriler içerirken, veri havuzları çeşitli veri türlerini destekleyebilir. Örneğin, merkezi bir veri havuzu, ilişkisel veri tabanları veya bir veri ambarı dahil olmak üzere diğer platformlarla entegre edilebilir. Big Data sistemlerinde bulunan veriler, işlenmeden ham olarak bırakılabilir. Daha sonra belli analitik işlemler için düzenlenerek kullanılabilir. Diğer durumlarda veri madenciliği araçları ve veri hazırlama yazılımı kullanılarak önceden işlenir. Böylece düzenli olarak çalıştırılan uygulamalar için hazır olur.

Big Data Nasıl İşlenir?

Büyük veri işleme bilgi işlem altyapısına ağır talepler getirir. Kuruluşlar, kendi bulut tabanlı sistemlerini devreye alabilir veya bulut sağlayıcılarının sunduğu yönetilen bir hizmet olarak Big Data tekliflerini kullanabilir. Bulut kullanıcıları, büyük veri analizi projelerini tamamlamak için gereken sayıda sunucuyu ölçeklendirebilir. İşletme yalnızca kullandığı depolama ve işlem süresi için ödeme yapar ve bulut örnekleri yeniden ihtiyaç duyulana kadar kapatılabilir.

Big Data Analizi Nasıl Çalışır?

![]()

Büyük veri analitiği uygulamalarından geçerli ve alakalı sonuçlar elde etmek için veri bilimcileri ve diğer veri analistleri, mevcut veriler hakkında ayrıntılı bir anlayışa ve onda ne aradıklarına dair bir fikre sahip olmalıdır. Bu, veri setlerinin profil oluşturma, temizleme, doğrulama ve dönüşümünü içeren veri hazırlığını analitik süreç için çok önemli bir ilk adım haline getirir.

Veriler toplanıp analiz için hazırlandıktan sonra, büyük veri analitiği sağlayan araçlar kullanılarak farklı uygulamaları çalıştırmak için çeşitli veri bilimi ve gelişmiş analitik disiplinleri uygulanabilir. Bu disiplinler arasında makine öğrenimi ve derin öğrenme dalı, tahmine dayalı modelleme, veri madenciliği, istatistiksel analiz, akış analitiği, metin madenciliği ve daha fazlası yer alır.

Big Data kümeleriyle yapılabilecek farklı analitik dalları şunları içerir:

Karşılaştırmalı analiz: Bir şirketin ürünlerini, hizmetlerini ve markalaşmasını rakiplerininkilerle karşılaştırmak için müşteri davranışı ölçümlerini ve gerçek zamanlı müşteri katılımını inceler.

Sosyal medya dinleme: İnsanların sosyal medyada bir işletme veya ürün hakkında söylediklerini analiz ederek potansiyel sorunları belirlemeye ve pazarlama kampanyaları için hedef kitleye yardımcı olabilir.

Pazarlama taktikleri: Pazarlama ürünleri, çeşitli hizmetler ve birçok ticari girişim için kampanyaları ve müşteriye sunulacak teklifleri daha iyi hale getirmek için kullanılacak veri sağlar

Duygu analizi: Müşteriler hakkında toplanan tüm veriler, bir şirket veya marka hakkında nasıl hissettiklerini, müşteri memnuniyet düzeylerini, olası sorunları ve müşteri hizmetlerinin nasıl iyileştirilebileceğini ortaya çıkarmak için analiz edilebilir.

Büyük Veri Yönetimi Teknolojileri

2006’da piyasaya sürülen açık kaynaklı bir dağıtılmış işleme çerçevesi olan Hadoop, başlangıçta çoğu büyük veri mimarisinin merkezindeydi. Spark ve diğer işleme motorlarının geliştirilmesi, Hadoop’ta yerleşik motor olan MapReduce’u arka planda bıraktı. Sonuç olarak farklı uygulamalar için kullanılabilen ancak genellikle birlikte dağıtılan bir büyük veri teknolojileri ekosistemi ortaya çıktı. Bilgi teknolojileri satıcıları tarafından sunulan büyük veri platformları ve yönetilen hizmetler, bu teknolojilerin çoğunu, öncelikle bulutta kullanım için tek bir pakette birleştirir. Onlardan bazıları: Amazon EMR (eski adıyla Elastic MapReduce), Cloudera Veri Platformu, Google Cloud Dataproc, HPE Ezmeral Data Fabric (eski adıyla MapR Veri Platformu) ve Microsoft Azure HDInsight.

Big Data Zorlukları Nelerdir?

İşlem kapasitesi sorunlarıyla bağlantılı olarak, büyük bir veri mimarisi tasarlamak, kullanıcılar için büyük bir zorluktur. Büyük veri sistemleri, bir kuruluşun özel ihtiyaçlarına göre uyarlanmalıdır. Big Data sistemlerini devreye almak ve yönetmek, ilişkisel yazılıma odaklanan veri tabanı yöneticilerinin ve geliştiricilerinin tipik olarak sahip oldukları becerilere kıyasla yeni beceriler de gerektirir. Bu sorunların her ikisi de yönetilen bir bulut hizmeti kullanılarak hafifletilebilir. Ancak BT yöneticilerinin maliyetlerin kontrolden çıkmamasını sağlamak için bulut kullanımını yakından takip etmesi gerekir. Ayrıca, şirket içi veri kümelerinin taşınması ve iş yüklerinin buluta işlenmesi genellikle karmaşık bir süreçtir.

Big Data sistemlerini yönetmedeki diğer zorluklar arasında, özellikle farklı platformların ve veri depolarının bir karışımını içeren dağıtılmış ortamlarda, verilerin veri bilimcileri ve analistleri için erişilebilir hale getirilmesi yer alır. Analistlerin ilgili verileri bulmasına yardımcı olmak için veri yönetimi ve analitik ekipleri, giderek artan şekilde meta veri yönetimi ve veri kökeni işlevlerini içeren veri katalogları oluşturuyor. Büyük veri kümelerini entegre etme süreci, özellikle veri çeşitliliği ve hızı faktörler olduğunda karmaşık hale geliyor.

Etkili Big Data Stratejisinin Anahtarları

Bir kuruluşta, bir büyük veri stratejisi geliştirmek, iş hedeflerinin ve şu anda kullanımda olan verilerin anlaşılmasını ve ayrıca hedeflere ulaşılmasına yardımcı olmak için ek veri ihtiyacının değerlendirilmesini gerektirir. Atılacak diğer adımlar şu şekilde sıralanabilir: Planlı kullanım durumlarına ve uygulamalara öncelik vermek; ihtiyaç duyulan yeni sistemlerin ve araçların belirlenmesi; bir dağıtım yol haritası oluşturmak ve yeniden eğitim veya işe almanın gerekli olup olmadığını görmek için iç becerilerin değerlendirilmesi.

Büyük veri kümelerinin temiz, tutarlı ve düzgün kullanılmasını sağlamak için bir veri yönetişim programı ve ilgili veri kalitesi yönetimi süreçleri de öncelikli olmalıdır. Büyük verileri yönetmek ve analiz etmek için en iyi uygulamalar, mevcut teknolojiler üzerinden bilgi için iş gereksinimlerine odaklanmayı ve veri keşfi ve analizine yardımcı olmak için veri görselleştirmeyi kullanmayı içerir.

Big Data Toplama Yasal Uygulamaları ve Düzenlemeleri

Büyük verinin toplanması ve kullanılması arttıkça, verinin kötüye kullanılması potansiyeli de artmaktadır. Veri ihlalleri ve diğer kişisel mahremiyet ihlalleriyle ilgili kamuoyunun tepkisi, Avrupa Birliği’nin Mayıs 2018’de yürürlüğe giren veri gizliliği yasası olan Genel Veri Koruma Yönetmeliğini (GDPR) onaylamasına yol açtı. GDPR, kuruluşların toplayabileceği veri türlerini sınırlar ve isteğe bağlı olarak seçmeyi gerektirir (kişilerin rızasıyla veya kişisel verilerin toplanmasına ilişkin diğer belirtilen nedenlere uygun olarak). Ayrıca, AB sakinlerinin şirketlerden verilerini silmelerini istemesine olanak tanıyan bir unutulma hakkı hükmü de içeriyor.

ABD’de benzer federal yasalar bulunmamakla birlikte, Kaliforniya Tüketici Gizliliği Yasası (CCPA), Kaliforniya sakinlerine, eyalette iş yapan şirketler tarafından kişisel bilgilerinin toplanması ve kullanılması üzerinde daha fazla kontrol sağlamayı amaçlamaktadır. CCPA 2018’de kanuni olarak imzalandı ve 1 Ocak 2020’de yürürlüğe girdi. Bu tür yasalara uyduklarından emin olmak için işletmelerin büyük veri toplama sürecini dikkatli bir şekilde yönetmesi gerekir. Düzenlenmiş verileri tanımlamak ve yetkisiz çalışanların bunlara erişmesini önlemek için kontroller uygulanmalıdır.

Big Data Tarihi

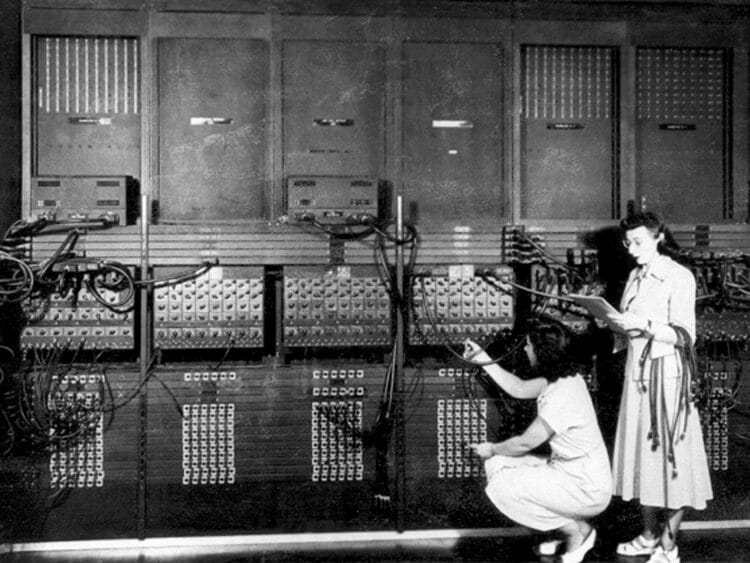

Veri toplama, eski uygarlıkların yiyecekleri takip ederken çubuk sayımlarını kullanmasına kadar dayandırılabilir ancak büyük verilerin tarihi gerçekten çok daha sonra başlar. İşte bizi bugün olduğumuz yere getiren bazı önemli anların kısa bir zaman çizelgesi.

1881: Veri yüklemesinin ilk örneklerinden biri 1880 nüfus sayımı sırasında yaşandı. Hollerith tablolama makinesi icat edildi ve nüfus sayımı verilerinin işlenmesi işi on yıllık emekten bir yılın altına indirildi.

1928: Alman-Avusturyalı mühendis Fritz Pfleumer, dijital verilerin önümüzdeki yüzyılda nasıl saklanacağının yolunu açan bant üzerinde manyetik veri depolama geliştirdi.

1948: Shannon’ın ‘Bilgi Teorisi’ geliştirildi ve bu teori günümüzde yaygın olarak kullanılan bilgi altyapısının temelini attı.

1970: IBM’de matematikçi olan Edgar F. Codd, Big Data tabanlarındaki bilgilere, yapısı veya konumu bilinmeden nasıl erişilebileceğini gösteren bir ‘ilişkisel veri tabanı’ sundu.

1976: Malzeme İhtiyaç Planlaması (MRP) sistemlerinin ticari kullanımı, bilgileri organize etmek ve planlamak için geliştirildi ve iş operasyonlarını hızlandırmak için daha yaygın hale geldi.

1989: World Wide Web, Tim Berners-Lee tarafından oluşturuldu.

2001: Doug Laney, büyük verinin temel özellikleri haline gelen ‘3 Vs of Data’yı açıklayan bir makale sundu. Aynı yıl ‘software-as-a-service (hizmet olarak yazılım)’ terimi ilk kez paylaşıldı.

2005: Büyük veri kümesinin depolaması için açık kaynaklı yazılım çerçevesi olan Hadoop oluşturuldu.

2007: ‘Big Data’ terimi, Wired’ın ‘Teorinin sonu: Veri tufanı bilimsel yöntemi eski haline getiriyor’ başlıklı makalesinde geniş kitlelere tanıtılıyor. (The End of Theory: The Data Deluge Makes the Scientific Method Obsolete)

2008: Bilgisayar bilimi araştırmacılarından oluşan bir ekip, büyük verilerin şirketlerin ve kuruluşların iş yapma biçimini temelden nasıl değiştirdiğini açıklayan ‘Büyük veri hesaplama: Ticaret, bilim ve toplumda devrimsel atılımlar yaratmak” başlıklı makaleyi yayınladı. (Big Data Computing: Creating Revolutionary Breakthroughs in Commerce, Science and Society,)

2010: Google CEO’su Eric Schmidt, her iki günde bir, insanların medeniyetin başlangıcından 2003 yılına kadar yarattıkları kadar bilgi ürettiğini ortaya koydu.

2014: Gittikçe daha fazla şirket Kurumsal Kaynak Planlama Sistemlerini (Enterprise Resource Planning Systems) buluta taşımaya başladı. Nesnelerin interneti ( The Internet of things ), her gün büyük miktarda veri ileten tahmini 3,7 milyar bağlı cihaz veya kullanımda olan şeylerle yaygın olarak kullanılmaya başlandı.

2016: Obama yönetimi, topluma ve ekonomiye doğrudan fayda sağlayacak büyük veri uygulamalarının araştırılmasını ve geliştirilmesini sağlamak için tasarlanmış ‘Federal Büyük Veri Araştırma ve Stratejik Kalkınma Planı’nı yayınladı. (Federal Big Data Research and Strategic Development Plan)

2017: IBM araştırması, günlük 2,5 kentilyon bayt verinin oluşturulduğunu ve dünyadaki verilerin %90’ının son iki yılda oluşturulduğunu söyledi.

Big Data Neden Bu Kadar Popüler Oldu?

Büyük verinin son zamanlardaki popülaritesi büyük ölçüde, çok fazla verinin işlenmesine, depolanmasına ve analizine izin veren teknoloji ve altyapıdaki yeni gelişmelerden kaynaklanmaktadır. Bilgi işlem gücü, son beş yılda önemli ölçüde artarken, aynı zamanda fiyat düşerek küçük ve orta ölçekli şirketler için daha erişilebilir hale geldi. Teknoloji daha güçlü ve daha ucuz hale geldikçe, işletmelerin sunduğu tüm büyük veriden yararlanmalarına yardımcı olan ürünler ve hizmetler yaratarak çok sayıda şirket ortaya çıktı.

Big Data Yönetimi ve Analitiğinin İnsani Yönü

Sonuç olarak, büyük veri girişimlerinin iş değeri ve faydaları, verileri yönetmek ve analiz etmekle görevli çalışanlara bağlıdır. Bazı büyük veri araçları, daha az teknik kullanıcının tahmine dayalı analitik uygulamaları çalıştırmasını sağlar veya işletmelerin büyük veri projeleri için uygun bir altyapı kurmasına yardımcı olurken, donanım ve dağıtılmış yazılım bilgisi ihtiyacını en aza indirir. Büyük veri, bazen self servis BI ve analitik için kolayca kullanılabilen veri kümelerini tanımlamak için kullanılan bir terim olan küçük verilerle karşılaştırılabilir. Büyük veri denilince en çok sarf edilen cümlelerden biriyle yazımızı bitirelim: “Büyük veri makineler içindir; küçük veri insanlar içindir.”

This post is also available in: English

Yorumlar (0) Yorum Yap